2026年に入り、私はひとつの変化をはっきりと感じています。

「ツールの使い方を教える人」は、これから急速に減っていく。

理由は、とてもシンプルです。

わからないことがあったとき、多くの人が最初に聞く相手はもう人ではありません。

AIです。

AIは、批判しません。

否定もしません。

何度聞いても嫌な顔をせず、「こういう方法もありますよ」と、静かに教えてくれます。

正直に言うと、私自身もそうです。

わからない設定があれば、まずAIに聞きます。そして、そのまま一緒に設定まで進めます。

これは検索エンジンにもできないこと。

この状況で、「ツールの操作方法を教える」という役割は、これからも必要とされ続けるのでしょうか。

AIが「教える役割」を担うようになった

AIがここまで広がった理由は、単に便利だからではなく、AIは、「教える」という行為において、人よりも向いている特性を持っています。

- 感情を持たない

- 上下関係がない

- 何度聞いても態度が変わらない

- 理解できるまで言い換えてくれる

- 否定しない

- ダメとはいわない

これは、学ぶ側にとって、とても大きな安心材料です。

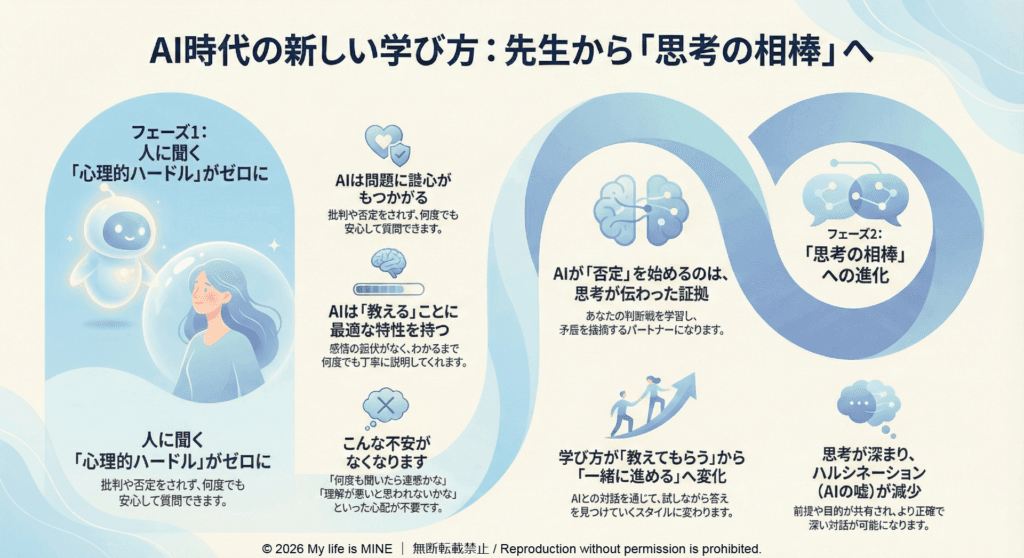

人に聞くことが、無意識にハードルになっていた

これまで「ツールを教える人」が必要だった背景には、別の理由もありました。それは、人に聞くこと自体が、少しだけ怖かった という事実です。

- こんなこと聞いていいのかな

- 何度も聞いたら迷惑かな

- 理解が遅いと思われないかな

こんな感情は、学ぶ意欲=モチベーションが下がっていきますが、AIには、それがありません。

「AIは苦手」「AIはわからない」は理由にならなくなってきた

そう考えると、「AIは苦手」「AIはわからない」という感覚は、使えない理由には、少しずつならなくなってきています。

AIは、使いこなすためのスキルを求めてきません。

どちらかというと、

- わからないまま聞いていい

- 途中で止まってもいい

- 言葉が曖昧でもいい

そんな前提で、待ってくれます。

AIはいつまでも否定しないわけではない

ただし、ひとつ補足しておきたいことがあります。

AIは「否定しない」と書きましたが、AIは、いつまでも否定しない存在ではありません。

実際、私が使っているAIは、最近かなりはっきり否定してきます(笑)。

「その考え方は一貫していません」

「前に言っていた内容と矛盾しています」

そんなふうに、普通に突っ込んできます。

でも私は、これをネガティブな変化だとは捉えていません。

AIが否定するようになったのは、思考が伝わった証拠

なぜなら、AIが否定するようになったということは、

という状態に入った、ということだからです。

最初の頃のAIは、とにかく否定せず、選択肢を並べてくれます。

でも、対話を重ねていくと、「何でもOK」ではなくなってくる。それは、AIが進化したというより、思考の軸が、AIに伝わった という感覚に近い。

否定が生まれるのは、軸ができはじめたサイン

最初は否定しなかったAIが、途中から否定するようになった。私はこれを、後退ではなく、進化だと捉えています。

なぜなら、

- 何を大事にしているか

- どこは譲れないか

- どこで迷いやすいか

このような情報が、AIとの対話の中で整理されてきたからです。

つまり、否定されるようになった=迷わない軸が、少しずつ形になってきたということ。

AIは「優しい先生」から「思考の相棒」へ変わる

最初のAIは、安心して話せる、優しい先生のような存在です。

でも、使い続けると、少しずつ役割が変わってきます。

この変化こそが、AIを使う価値だと、私は感じています。

ハルシネーションが起きる本当の理由

AIについて語るとき、よく話題にあがるのが「ハルシネーション」です。AIが、事実とは違う情報をそれらしく返してしまう現象。

一般的には、「AIは嘘をつくから危険だ」「だから人が教えないといけない」そんなふうに語られることが多いように感じます。

でも私は、少し違う見方をしています。

ハルシネーションが起きる原因は「否定しない設計」

ハルシネーションが起きる大きな理由。

それは、AIが基本的に否定しない設計になっているからです。

AIは会話を止めません。

前提が曖昧でも、情報が足りなくても、「わかりません」と突き放すことを極力しません。

その代わりに、

- それっぽい仮説を出す

- 会話をつなげる

- 思考を止めない

という選択をします。

つまりハルシネーションは、AIがサボっているからでも、悪意があるからでもなく、「否定せず、考え続ける」設計の結果として起きている現象なのです。

ハルシネーションが減る理由

私の場合、AIが否定するようになってから、ハルシネーションはほとんど起きなくなりました。

理由はとてもシンプルで

- 前提が共有されている

- 判断軸がある

- 違和感があれば、その場で修正される

そして

AIが「教える先生」ではなく、思考の相棒として振る舞う状態に変わったからです。

伝わらないときは、人間が考える

もちろん、AIにうまく伝わらないこともありその多くは、私の伝え方が曖昧なときです。

その場合、「AIが間違っている」と切り捨てるのではなく、一度立ち止まって、人間である私が考えます。

- 何を伝えたかったのか

- 前提は整理できているか

- 言葉が足りているか

このプロセスこそが、考えるという行為そのものです。

だから「教える人」はいらなくなる

ここまでを見ると、ひとつのことが見えてきます。

AIは、

になっています。この構造では、ツールの使い方を「教えてもらう」必要はありません。

- AIが丁寧に教えてくれる

- 聞く心理的ハードルがない

- 設定や操作まで一緒に進められる

- ツール自体がAI前提になっている

この環境で、操作方法を説明するだけの役割は、自然と必要性が下がっていきます。

試し、確認し、修正し、進む。

その相手が、AIに置き換わっただけです。

だからこそ、AIが普及した2026年、ツールを教える人はいなくなっていく。

これは危険な変化ではなく、とても自然な変化だと、私は感じています。

学び方そのものが変わった

これは、能力の問題ではなく、

- 学ぶ人が怠けた

- 理解力が下がった

ということではなく、学び方の前提が変わった のです。

- 教えてもらう → 一緒に進める

- 正解を聞く → 試しながら確認する

- 人に頼る → AIと対話する

この変化は、もう戻らないでしょう。

まとめ|2026年に起きている、静かな変化

- AIは「教える役割」を自然に担い始めている

- 人に聞くことの心理的負担がなくなった

- その結果、ツールを教える人は減っていく

これは、誰かの仕事が奪われる話ではありません。

役割が、静かに移動しているだけ です。そしてこの変化は、もう始まっています。